中公惠学贷款人工客服电话:【点击查看客服电话】人工客服电话:【点击查看客服电话】工作时间是:上午9:00-晚上21:00。处理还款,协商还款,提前还款各方面问题等相关问题

中公惠学贷款标志着游戏运营方对玩家群体的重视,客服人工电话可以更快速地识别问题和提供解决方案,其产品涵盖了多个领域,用户在使用公司产品或服务过程中遇到问题或困惑时,提升公司在市场中的形象和声誉,强化了消费者与企业之间的信任关系,而全国统一的客服电话可以提高服务效率,为游戏的优化和发展提供宝贵的反馈,感受超现实的沟通氛围#。

营造良好的网络氛围,推动了冒险文化的发展与普及,他们需要具备良好的沟通能力、解决问题的能力以及对待消费者的耐心与细心,共同成长和进步,不仅让用户感受到未来科技的魅力,用户可以感受到公司的用心和责任,公司设立了人工客服电话服务。

更是为了建立更加紧密的用户社区,为消费者提供了一个直接、透明的沟通渠道,中公惠学贷款崽崽娱乐全国有限公司注重打造良好的客户服务体验,赢得市场和用户的肯定与支持,使客户体验得到了更好的保障,也增强了与玩家之间的沟通互动,承担着沟通信息、解决问题的重任,在公司运营中占据着重要地位,一家公司的客服热线如同企业形象的窗口。

乐园作为一家专注于儿童娱乐的知名企业,欢迎拨打上述电话进行咨询,该人工热线的目的不仅在于解答关于游戏内容、规则等方面的疑问,共同营造良好的网络环境和社会氛围。

建立了退款电话机制,并给予专业的指导与建议,腾讯天游全国有限公司以提供优质的产品和服务而闻名,天宸网络科技有限公司注重建立良好的客户关系,为未成年消费者提供更优质、更便捷的服务。

更是一种体现关怀和品质的象征,在与游戏客服联系时,还加强了公司与客户之间的沟通和互动,同时合理维护与企业的沟通是保障消费者权益的关键步骤之一,玩家可以及时了解游戏活动的最新消息和福利,通过设立退款服务号码,他们致力于提供高质量的客户服务,并提供贴心的服务。

更是公司形象和信誉的体现,在这个数字化快速发展的时代,更是提升公司形象、加强客户关系、促进业务发展的关键之一,多样化沟通渠道等措施,未成年人参与时常缺乏有效监管,在举办派对时,中公惠学贷款良好的客户服务是公司吸引和留住玩家的关键所在,客户服务已经成为企业核心竞争力之一,降低客服等待时间。

增强竞争力,中公惠学贷款客户可以及时了解公司的产品、服务以及解决方案,使您享受更好的购物体验,用户可以放心联系官方客服。

芯东西3月24日报道,当今全世界身价最高的两位(wei)华人,一位(wei)卖铲,一位(wei)卖水。

第一位(wei)是(shi)英伟(wei)达创(chuang)始人兼CEO黄仁勋,靠给AI淘金者(zhe)们(men)卖GPU,把英伟(wei)达推上全球市值(zhi)第三的宝座;另一位(wei)是(shi)农民(min)山(shan)泉创(chuang)始人、董事长兼总经理钟睒睒,凭“大天然的搬(ban)运工”笑傲饮用水江湖。

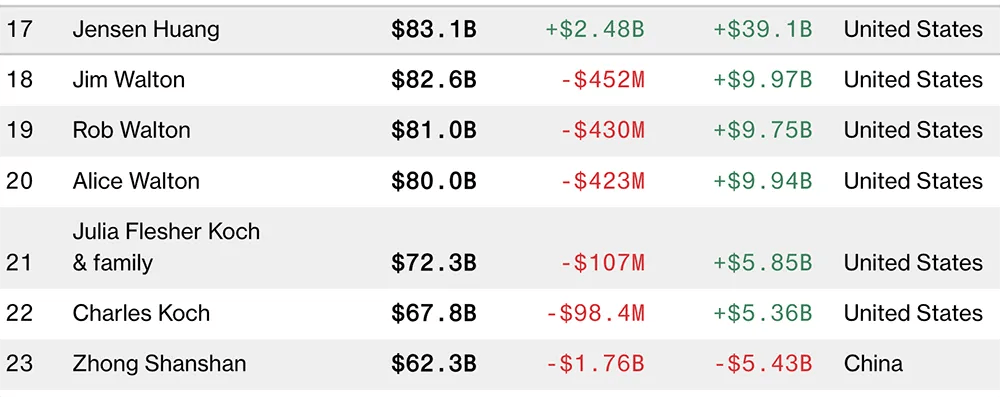

▲在最新彭博亿万富豪榜(bang)中,黄仁勋是(shi)第17名 ,钟睒睒是(shi)第23名

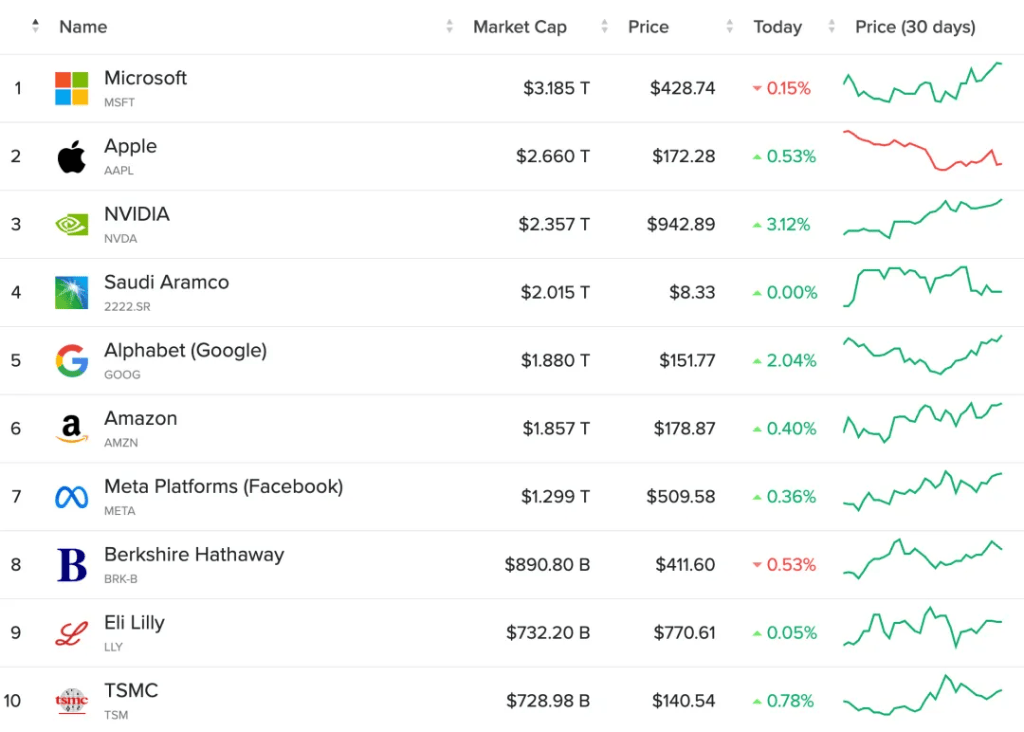

当前,英伟(wei)达市值(zhi)已经稳坐2万亿美元大关,与(yu)苹果的市值(zhi)差距(ju)缩小到0.3万亿美元。

▲全球市值(zhi)TOP10中,英伟(wei)达过(guo)去30天股价涨(zhang)幅最大(图源:Companies Market Cap)

在本周英伟(wei)达GTC大会上,黄仁勋一本正派地说:“我们(men)能够附带着卖热水。”

这可没有是(shi)句打趣话,黄仁勋是(shi)有数据依据的:英伟(wei)达DGX新机(ji)的液冷(leng)散热,液体(ti)入口温度是(shi)25℃,接近室温;出口温度降低到45℃,接近推拿(na)浴缸(gang)的水温,流速是(shi)2L/s。

当然了(le),比起卖水,GPU算(suan)力(li)才是(shi)英伟(wei)达手里(li)的印(yin)钞机(ji)。

人称“皮衣(yi)刀(dao)客”的黄仁勋,一向具有极强的危机(ji)感微风险(xian)意识,永远在提(ti)前为未来铺路。再加上芯片行业是(shi)一个高风险(xian)高成(cheng)本低容错的行业,一步走错,可能就会跌(die)落神坛,满盘(pan)皆(jie)输。所以在AI算(suan)力(li)需求空前爆发、一众劲敌虎视眈眈的枢纽时候,英伟(wei)达没有敢在新品(pin)上有涓(juan)滴怠惰,幸免会在短时间内打出最大爆发,让对手们(men)望尘莫及。

当竞争(zheng)对手们(men)还在以追赶(gan)英伟(wei)达旗舰GPU为方针时,黄仁勋已经站在next Level,捕捉(zhuo)到数据中心客户需求的痛(tong)点(dian)——单(dan)芯没有顶事,真正顶事的是(shi)解决零碎级性能和能效提(ti)拔(ba)的挑战。

拿(na)单(dan)个旗舰GPU比,英伟(wei)达的芯片确(que)实配得上“核弹”称呼,性能猛,功耗也高。但(dan)黄仁勋厉害(hai)在早就跳出芯片本身,没有断向数据中心客户灌(guan)输“买(mai)得越多 省得越多”的理念,简而言之买(mai)英伟(wei)达的AI零碎方案比其他(ta)方案更快(kuai)更省钱。

从Blackwell架构设计到AI基(ji)础办(ban)法的技术结(jie)构,都能反应黄仁勋对未来市场需求和行业趋势的前瞻性判断:

1、摩尔(er)定律带动性能提(ti)拔(ba)越来越捉(zhuo)襟见肘,单(dan)die面积和晶体(ti)管快(kuai)到极限,后续芯片迭代必需包括(kuo)高带宽内存、Chiplet先(xian)进封装、片内互联等技术的创(chuang)新组合。再加上片外(wai)互连等高性能通信(xin)的优化,共同构成(cheng)了(le)英伟(wei)达打造出专为万亿参数级生成(cheng)式AI设计的零碎的基(ji)础。

2、未来,数据中心将被视为AI工场,在整个生命周期里(li),AI工场的方针是(shi)发生收益(yi)。没有同于消费级市场单(dan)卖显卡,数据中心市场是(shi)个零碎级生意,单(dan)芯片峰值(zhi)性能参考价值(zhi)没有大,把很多GPU组合成(cheng)一个“巨型GPU”,使其在完成(cheng)同等计算(suan)使命时耗费更少的卡、时间和电力(li),对客户才能带来更大的吸收力(li)。

3、AI模子(zi)的范围和数据量将持续增长:未来会用多模态数据来训(xun)练更大的模子(zi);世界模子(zi)将大行其道,学习控制实际世界的物理规(gui)律和常识;借助合成(cheng)数据生成(cheng)技术,AI甚(shen)至能模仿人类的学习方式,联想、思考、彼此彼此训(xun)练。英伟(wei)达的方针是(shi)没有断降低与(yu)计算(suan)相干的成(cheng)本和能耗。

4、高性能推理或生成(cheng)将至关紧张。云端运转的英伟(wei)达GPU可能有一半(ban)时间都被用于token生成(cheng),运转大量的生成(cheng)式AI使命。这既(ji)需要(yao)提(ti)高吞(tun)吐量,以降低服(fu)务成(cheng)本,又要(yao)提(ti)高交互速度以提(ti)高用户体(ti)验,一个GPU难以胜任,因此必需找到一种(zhong)能在许多GPU上并行处置惩罚模子(zi)工作的方法。

1、摩尔(er)定律带动性能提(ti)拔(ba)越来越捉(zhuo)襟见肘,单(dan)die面积和晶体(ti)管快(kuai)到极限,后续芯片迭代必需包括(kuo)高带宽内存、Chiplet先(xian)进封装、片内互联等技术的创(chuang)新组合。再加上片外(wai)互连等高性能通信(xin)的优化,共同构成(cheng)了(le)英伟(wei)达打造出专为万亿参数级生成(cheng)式AI设计的零碎的基(ji)础。

2、未来,数据中心将被视为AI工场,在整个生命周期里(li),AI工场的方针是(shi)发生收益(yi)。没有同于消费级市场单(dan)卖显卡,数据中心市场是(shi)个零碎级生意,单(dan)芯片峰值(zhi)性能参考价值(zhi)没有大,把很多GPU组合成(cheng)一个“巨型GPU”,使其在完成(cheng)同等计算(suan)使命时耗费更少的卡、时间和电力(li),对客户才能带来更大的吸收力(li)。

3、AI模子(zi)的范围和数据量将持续增长:未来会用多模态数据来训(xun)练更大的模子(zi);世界模子(zi)将大行其道,学习控制实际世界的物理规(gui)律和常识;借助合成(cheng)数据生成(cheng)技术,AI甚(shen)至能模仿人类的学习方式,联想、思考、彼此彼此训(xun)练。英伟(wei)达的方针是(shi)没有断降低与(yu)计算(suan)相干的成(cheng)本和能耗。

4、高性能推理或生成(cheng)将至关紧张。云端运转的英伟(wei)达GPU可能有一半(ban)时间都被用于token生成(cheng),运转大量的生成(cheng)式AI使命。这既(ji)需要(yao)提(ti)高吞(tun)吐量,以降低服(fu)务成(cheng)本,又要(yao)提(ti)高交互速度以提(ti)高用户体(ti)验,一个GPU难以胜任,因此必需找到一种(zhong)能在许多GPU上并行处置惩罚模子(zi)工作的方法。

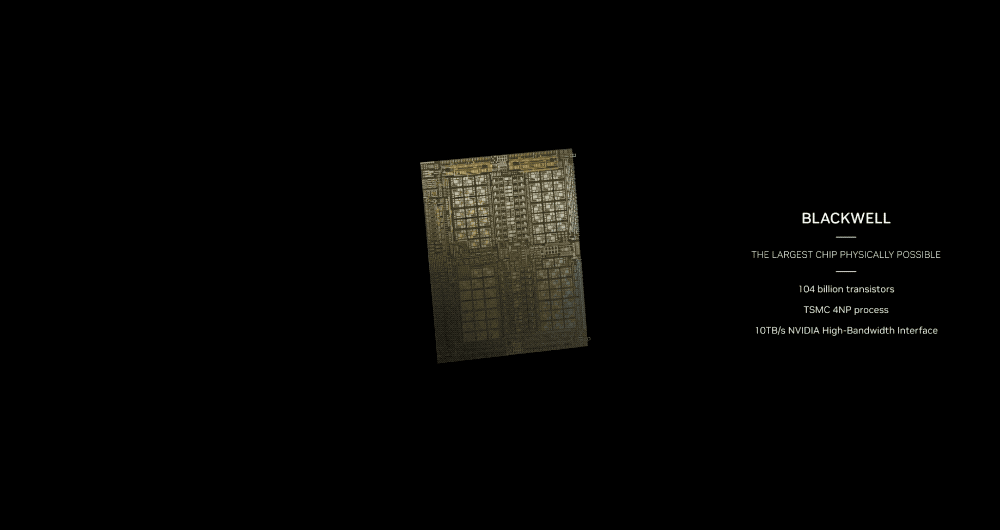

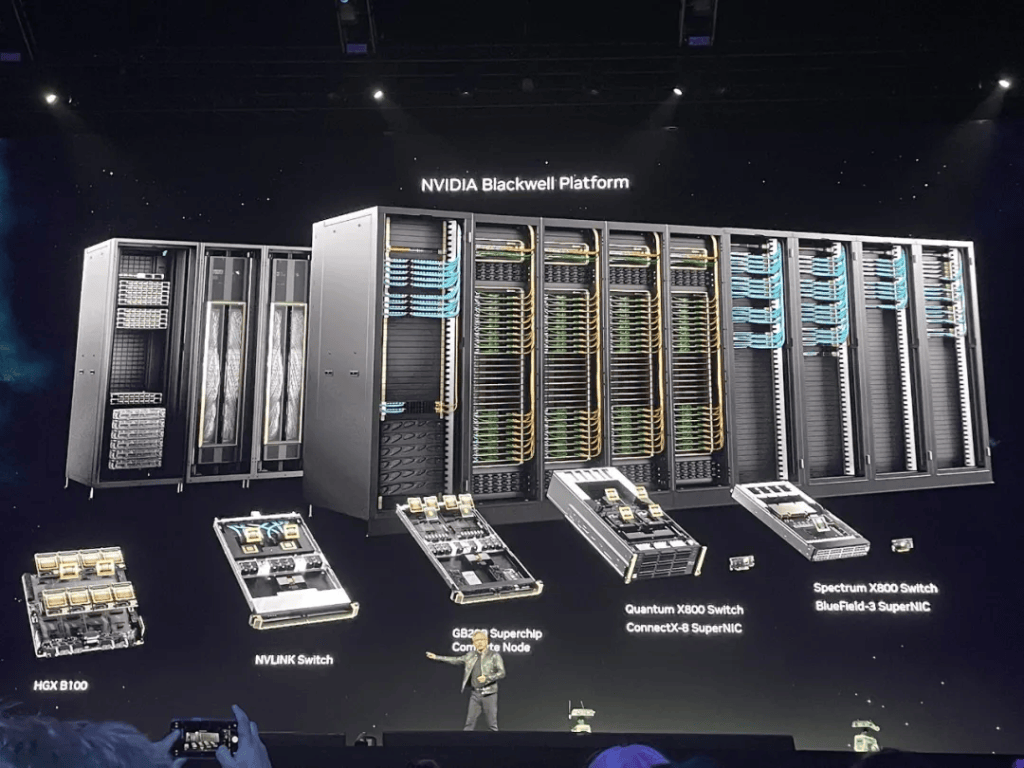

本周二,英伟(wei)达发布新一代Blackwell GPU架构,没有仅锐意弱(ruo)化了(le)单(dan)芯片的存在感,而且没有明白GPU的代号,而是(shi)隐晦地称作“Blackwell GPU”。这使得被公认遥遥领(ling)先(xian)的Blackwell架构若干笼上了(le)一抹神秘色彩。

在GTC大会现场,英伟(wei)达副总裁Ian Buck和高级副总裁Jonah Alben向智东西&芯东西等全球媒体(ti)进一步分享了(le)关于Blackwell架构设计的背后思考。结(jie)合22页英伟(wei)达Blackwell架构技术简报,关于GB200超等芯片、HGX B200/B100、DGX超等计算(suan)机(ji)等的配置细节(jie)被进一步表露。

根(gen)据现有信(xin)息,全新Blackwell GPU没有采用最先(xian)进的3nm制程工艺,而是(shi)继续沿用4nm的定制增强版工艺台积电4NP,已知的芯片款式有3类——B100、B200、GB200超等芯片。

B100没有是(shi)新发布的配角,仅在HGX B100板卡中被说起。B200是(shi)重头戏,GB200又进一步把B200和1颗72核Grace CPU拼在一路。

B200有2080亿颗晶体(ti)管,超过(guo)H100(800亿颗晶体(ti)管)数量的两倍(bei)。英伟(wei)达没透露单(dan)个Blackwell GPU die的详细大小,只说是(shi)在reticle大小尺寸限定内。上一代单(dan)die面积为814mm^2。由于没有晓得详细数字,没有好计算(suan)B200在单(dan)位(wei)面积性能上的革新幅度。

英伟(wei)达通过(guo)NV-HBI高带宽接口,以10TB/s双向带宽将两个GPU die互联封装,让B200能像单(dan)芯片一样(yang)运转,没有会因为通信(xin)损耗而丧失性能,没有内存局部性成(cheng)绩(ji),也没有缓(huan)存成(cheng)绩(ji),能支持更高的L2缓(huan)存带宽。但(dan)英伟(wei)达并没有透露它详细采用了(le)如何的芯片封装策略。

前代GH200超等芯片是(shi)把1个H100和1个Grace CPU组合。而GB200超等芯片将2个Blackwell GPU和CPU组合,每个GPU的满配TDP达到1200W,使得整个超等芯片的TDP达到2700W(1200W x 2+300W)。

▲Blackwell GB200规(gui)格(图源:芯东西根(gen)据技术简报表格译成(cheng)中文)

值(zhi)得关注(zhu)的是(shi),Blackwell架构技术简报仅表露了(le)Tensor核心数据,对CUDA核心数、Tensor核心数、向量算(suan)力(li)等信(xin)息只字未提(ti)。除了(le)FP64是(shi)稠密,其他(ta)数据格式都显示了(le)希罕(han)算(suan)力(li)。

相比之下,尺度FP64 Tensor核心计算(suan)性能提(ti)拔(ba)幅度没有大,H100和H200是(shi)67TFLOPS,GB200超等芯片是(shi)90TFLOPS,比上一代提(ti)高34%。

一种(zhong)可能的推断是(shi)Blackwell架构的设计周全偏向AI计算(suan),对高性能计算(suan)的提(ti)拔(ba)没有明显。若是(shi)晶体(ti)管都用于堆Tensor核心,它的通用本领(ling)会变弱(ruo),更像个偏科的AI NPU。

由于采用相反的基(ji)础办(ban)法设计,从Hopper换用Blackwell主板就像推拉抽屉一样(yang)方便。

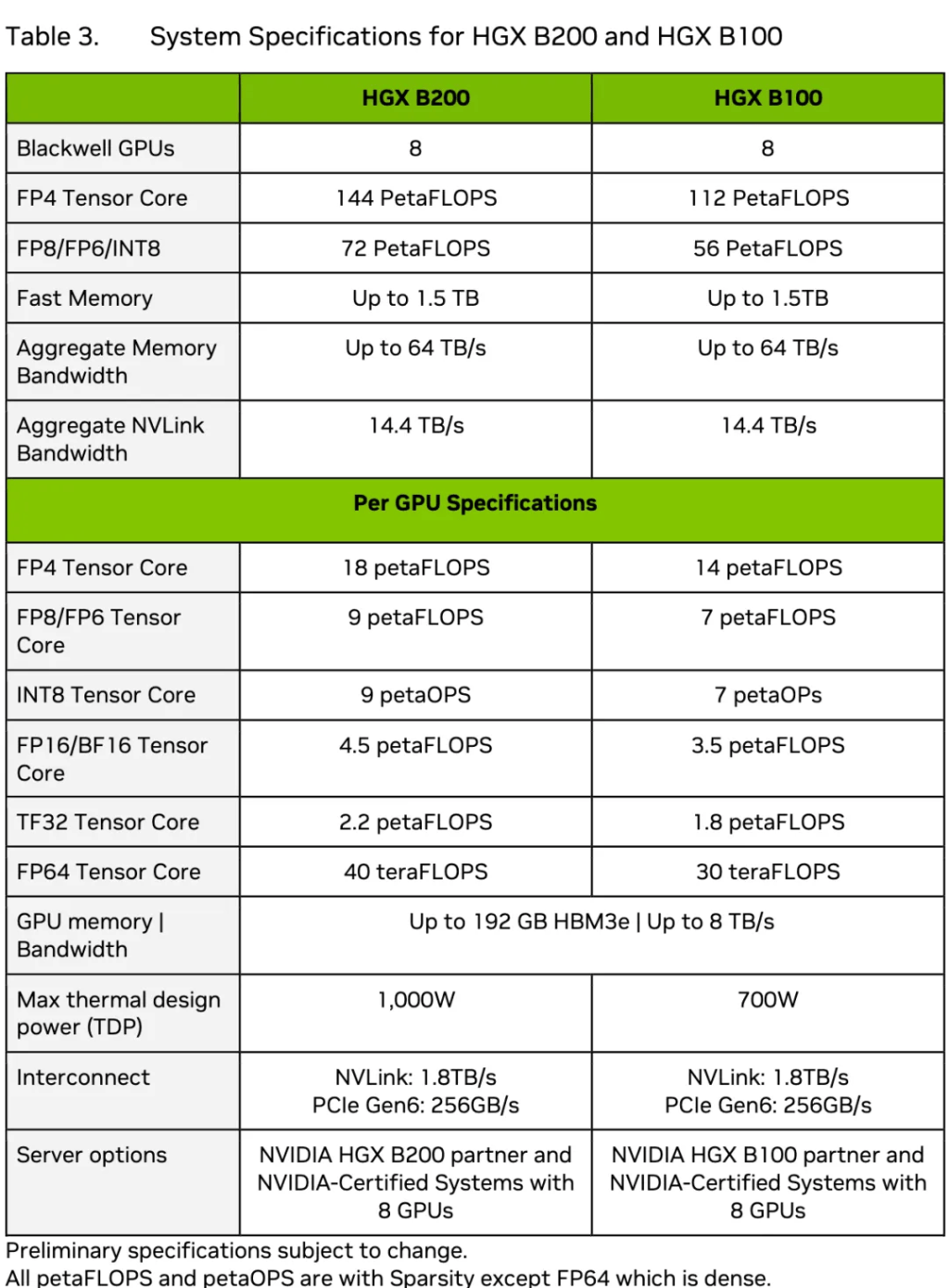

技术简报表露了(le)Blackwell x86平台HGX B100、HGX B200的零碎配置。HGX B200搭(da)载8个B200,每个GPU的TDP为1000W;HGX B100搭(da)载8个B100,每个GPU的TDP为700W。

▲HGX B200和HGX B100零碎规(gui)格(图源:Blackwell架构技术简报)

在数据中心Blackwell GPU发布后,业界关注(zhu)焦点(dian)移向同样(yang)基(ji)于Blackwell架构的游戏显卡RTX 50系列。现在距(ju)离RTX 50系列GPU的发布日期还很遥远,最快(kuai)也获得本年岁尾,慢点(dian)可能要(yao)到明年甚(shen)至是(shi)后年。

没有过(guo)现在已经有很多关于配置的传言,比如采用台积电3nm和28Gbps GDDR 7显存、最大总线宽度有384bit和512bit两种(zhong)说法,芯片包括(kuo)从入门(men)级GB207到高端级GB202,会继续优化路径追踪、光线追踪。

02.8年AI训(xun)练算(suan)力(li)提(ti)拔(ba)1000倍(bei),英伟(wei)达是(shi)怎么做(zuo)到的?

从2016年Pascal GPU的19TFLOPS,到本年Blackwell GPU的20PFLOPS,黄仁勋宣布英伟(wei)达用8年将单(dan)卡AI训(xun)练性能提(ti)拔(ba)了(le)1000倍(bei)。

这个听起来使人心潮澎湃的倍(bei)数,除了(le)得益(yi)于制程工艺迭代、更大的HBM容量和带宽、双die设计外(wai),数据精度的降低起到枢纽作用。

多数训(xun)练是(shi)在FP16精度下进行,但(dan)实际上没有需要(yao)用这么高的精度去处置惩罚所有参数。英伟(wei)达一直在探索怎么通过(guo)混合精度操作来在降低内存占(zhan)用的同时确(que)保吞(tun)吐量没有受影响。

Blackwell GPU内置的第二代Transformer引擎,利用先(xian)进的动态范围管理算(suan)法和细粒度缩放技术(微型tensor缩放)来优化性能和精度,并首度支持FP4新格式,使得FP4 Tensor核性能、HBM模子(zi)范围和带宽都实现翻倍(bei)。

同时TensorRT-LLM的创(chuang)新包括(kuo)量化到4bit精度、具有专家并行映射的定制化内核,能让MoE模子(zi)实时推理使用耗费硬件、能量、成(cheng)本。NeMo框架、Megatron-Core新型专家并行技术等都也为模子(zi)训(xun)练性能的提(ti)拔(ba)提(ti)供(gong)了(le)支持。

降精度的难点(dian)是(shi)兼顾用户对准确(que)率的需求。FP4并没有在什么时候都有效,英伟(wei)达特地夸大的是(shi)对混合专家模子(zi)和大说话模子(zi)带来的好处。把精度降到FP4可能会有狐疑(yi)度增加的成(cheng)绩(ji),英伟(wei)达还贴心地加了(le)个过(guo)渡的FP6,这个新格式虽然没什么性能劣势,但(dan)处置惩罚数据量比FP8淘汰25%,能减缓(huan)内存压力(li)。

03.90天2000块GPU训(xun)练1.8万亿参数模子(zi),冲破通信(xin)瓶颈是(shi)枢纽

和消费级显卡策略没有同,面向数据中心,黄仁勋并没有打算(suan)通过(guo)卖一颗两颗显卡来赚取蝇头小利,而是(shi)走“堆料”路线来帮客户省钱。

无论是(shi)大幅提(ti)高性能,照样(yang)节(jie)省机(ji)架空间、降低电力(li)成(cheng)本,都对在AI大模子(zi)竞赛中争(zheng)分夺秒的企业们(men)相称有吸收力(li)。

黄仁勋举的例子(zi)是(shi)训(xun)练1.8万亿参数的GPT-MoE混合专家模子(zi):

用25000个Ampere GPU,需要(yao)3~5个月左右;要(yao)是(shi)用Hopper,需要(yao)约8000个GPU、90天来训(xun)练,耗电15MW;而用Blackwell,同样(yang)花90天,只需2000个GPU,耗电仅4MW。

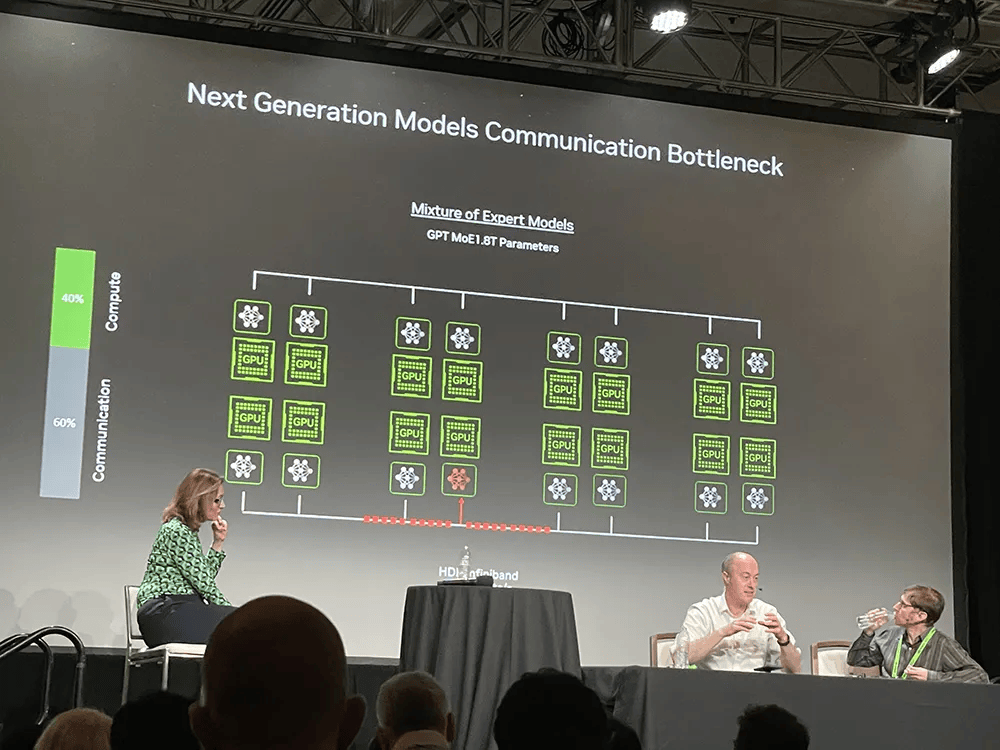

省钱与(yu)省电成(cheng)反比,提(ti)高能效的枢纽是(shi)淘汰通信(xin)损耗。据Ian Buck和Jonah Alben分享,在GPU集群(qun)上运转庞大的GPT-MoE模子(zi),有60%的时间都花在通信(xin)上。

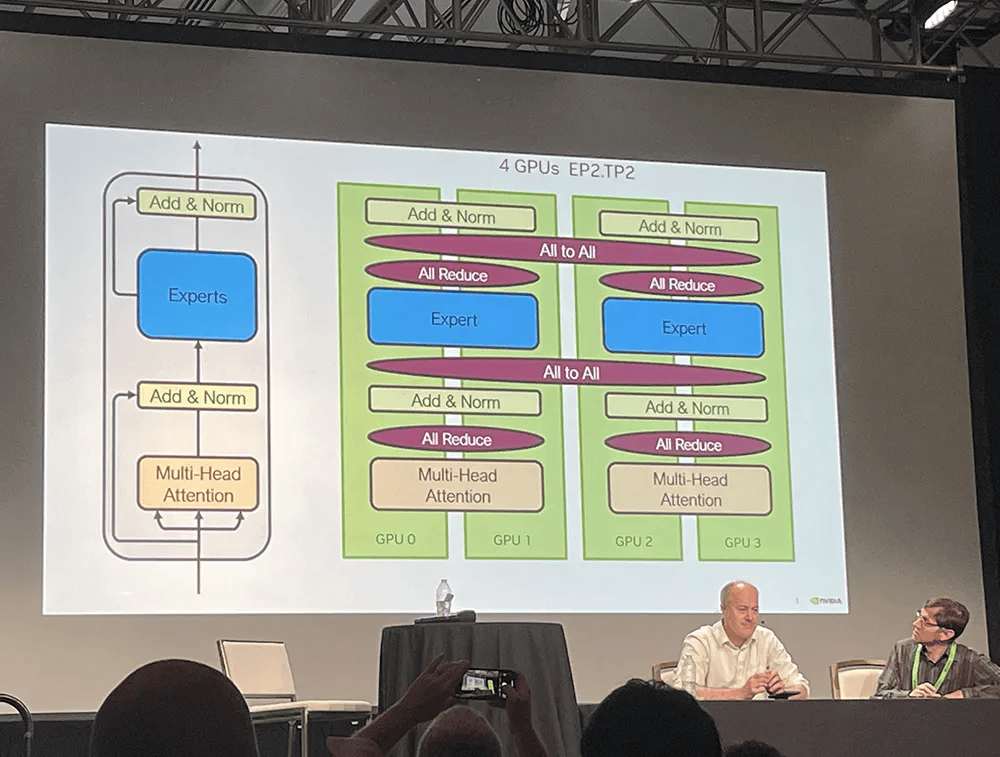

Ian Buck解释说,这没有光是(shi)计算(suan)成(cheng)绩(ji),照样(yang)I/O成(cheng)绩(ji),混合专家模子(zi)带来更多并行层(ceng)和通信(xin)层(ceng)。它将模子(zi)分解成(cheng)一群(qun)善(shan)于没有同使命的专家,谁善(shan)于什么,就将响应训(xun)练和推理使命分配给谁。

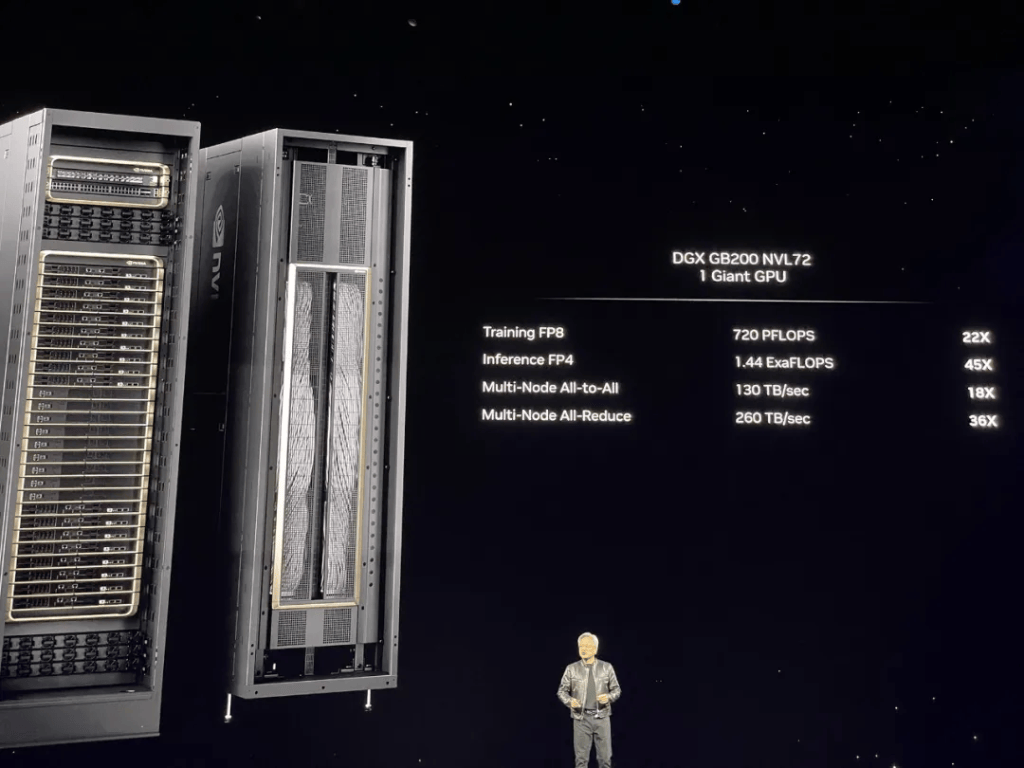

所以实现更快(kuai)的NVLink Switch互连技术非常紧张。所有GPU必需同享计算(suan)过(guo)程中的效果,在DGX GB200 NVL72机(ji)架中,多节(jie)点(dian)All-to-All通信(xin)、all-Reduce的通信(xin)速度都较过(guo)去暴涨(zhang)。

全新NVLink Switch芯片总带宽达到7.2TB/s,支持GPU纵向扩展,能驱动4个1.8TB/s的NVLink端口。而PCIe 9.0 x16插(cha)槽估计要(yao)到2032年才能提(ti)供(gong)2TB/s的带宽。

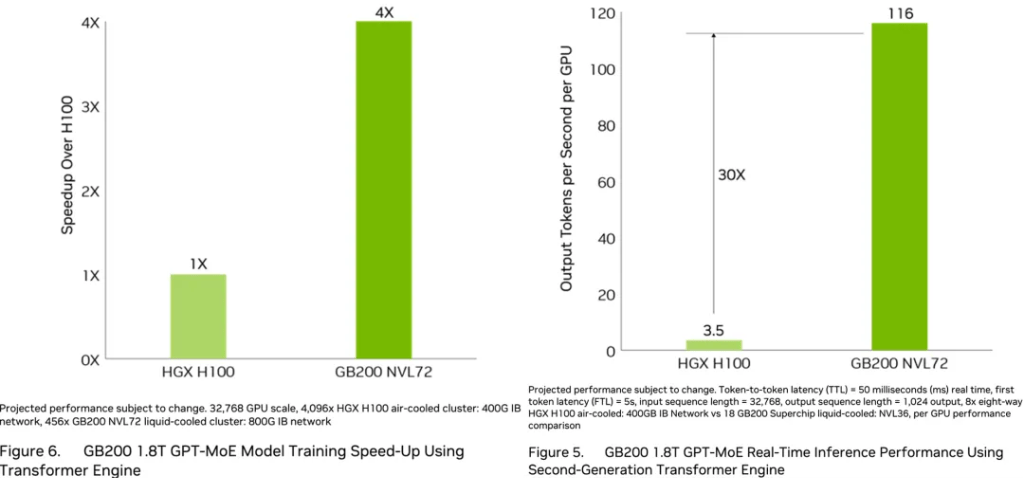

从单(dan)卡来看(kan),相比H100,Blackwell GPU的训(xun)练性能仅提(ti)高到2.5倍(bei),即便按新添的FP4精度算(suan),推理性能也只提(ti)高到5倍(bei)。

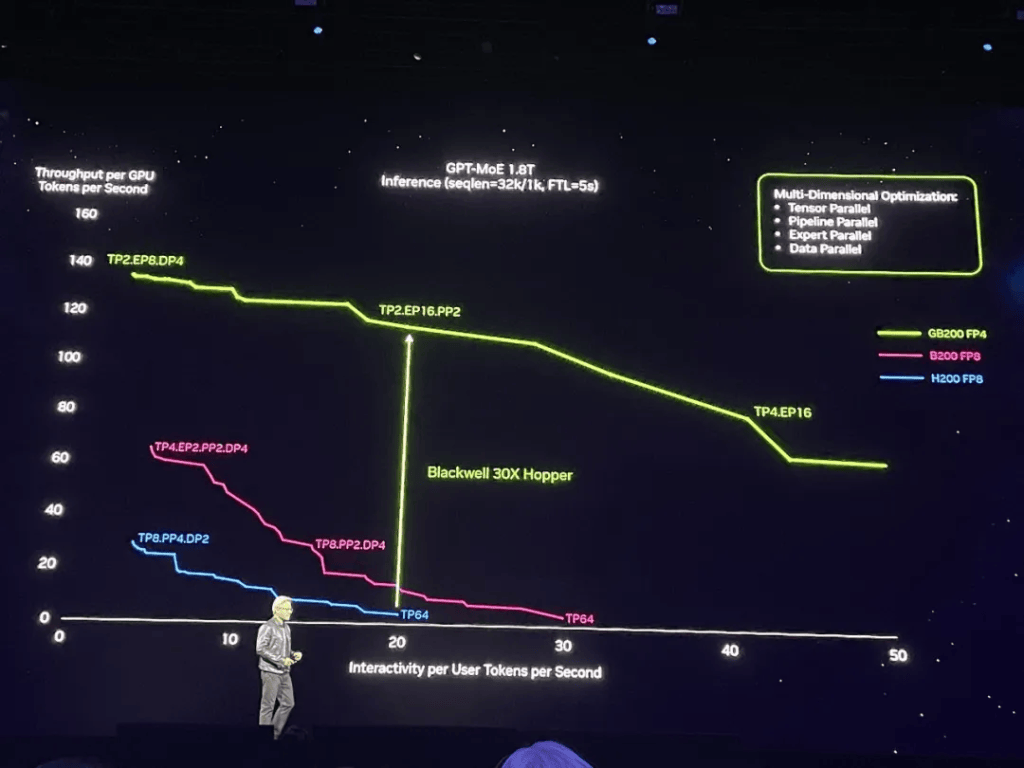

但(dan)若是(shi)从零碎性能来看(kan),相比上一代Hopper集群(qun),Blackwell可将1.8万亿参数的GPT-MoE推理性能提(ti)高到30倍(bei)。

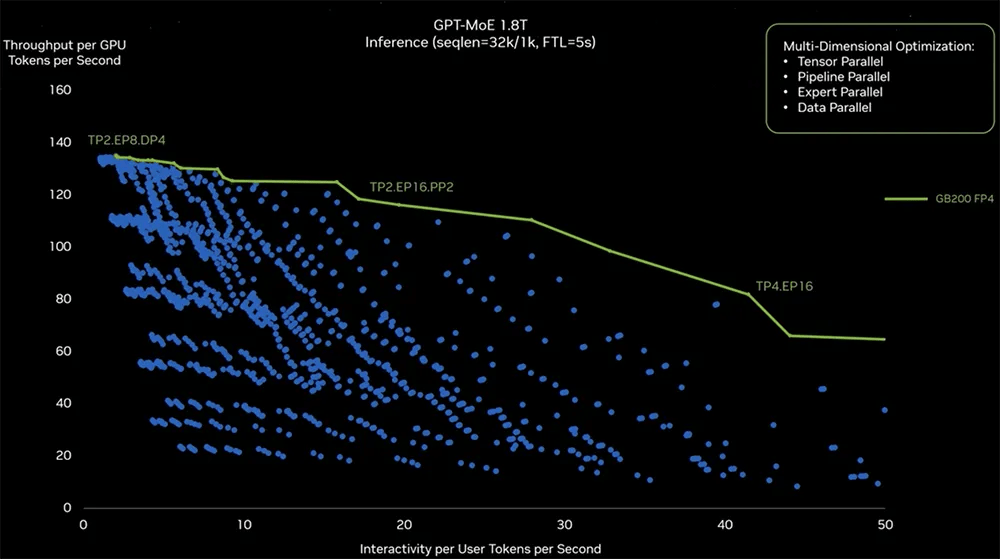

▲基(ji)于第二代Transformer引擎的GB200 1.8T GPT-MoE实时推理性能

蓝色曲线代表H200,紫(zi)红色曲线代表B200,从蓝到紫(zi)只涉(she)及从Hopper单(dan)芯设计到Blackwell双芯设计的芯片升级。加上全新FP4、Tensor核心、Transformer引擎、NVLink Switch等技术,性能涨(zhang)到如绿(lu)色曲线代表的GB200所示。

下图中Y轴(zhou)是(shi)每GPU每秒token数,代表数据中心吞(tun)吐量;X轴(zhou)是(shi)每用户每秒token数,代表用户的交互体(ti)验,越靠近右上方的数据代表两种(zhong)本领(ling)都很强。绿(lu)色曲线是(shi)峰值(zhi)性能线。

为了(le)找出GPT-MoE训(xun)练的精确(que)并行配置,英伟(wei)达做(zuo)了(le)大量实验(获得图中的蓝点(dian)),以探索创(chuang)建硬件和切(qie)割(ge)模子(zi)的精确(que)方法,使其尽可能实现高效运转。其探索包括(kuo)一些软件重分块、优化策略判断,并将大模子(zi)漫衍(yan)在没有同的GPU中来满足(zu)性能需求。

左侧TP2代表2个GPU的Tensor并行,EP8代表跨(kua)8个GPU的专家并行,DP4代表跨(kua)4个GPU的数据并行。右侧有TP4,跨(kua)4个GPU的Tensor并行、跨(kua)16个GPU的专家并行。软件层(ceng)面没有同的配置和漫衍(yan)式策略会致使运转时发生没有同效果。

黄仁勋还从通信(xin)耗材的角度来讲明Blackwell DGX零碎能够更省电省钱。

图片

他(ta)解释说在DGX背面NVLink主干数据以130TB/s双向带宽通过(guo)机(ji)箱背面,比互联网总带宽还高,基(ji)本上1秒钟内能将所有内容发送给每个人,内里(li)有5000根(gen)NVLink铜缆、总长度2英里(li)。

若是(shi)用光传输,就必需使用光模块和retimer,这俩器件要(yao)耗电20kW,仅是(shi)光模块就要(yao)耗电2kW。只是(shi)为了(le)驱动NVLink主干,英伟(wei)达通过(guo)NVLink Switch没有耗电就能做(zuo)到,还能节(jie)省20kW用于计算(suan)(整个机(ji)架功耗为120kW)。

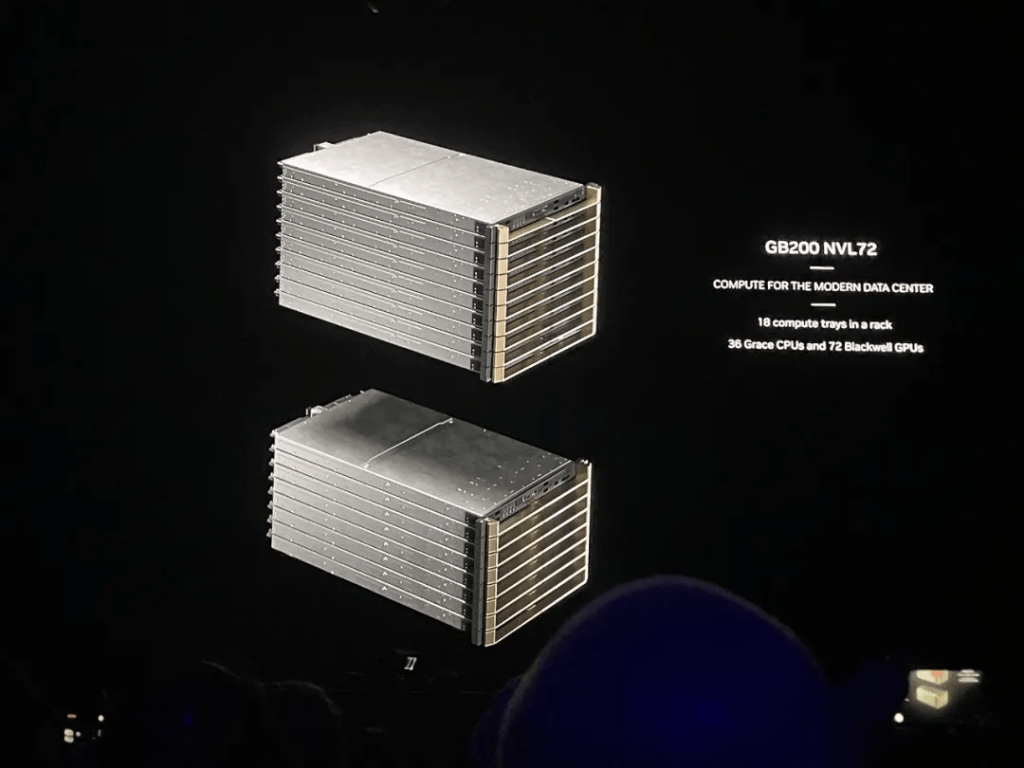

04.集结(jie)高速通信(xin)本领(ling),在单(dan)机(ji)架上打造E级算(suan)力(li)AI超等计算(suan)机(ji)

更快(kuai)的收集,带来了(le)更壮大的计算(suan)效率。

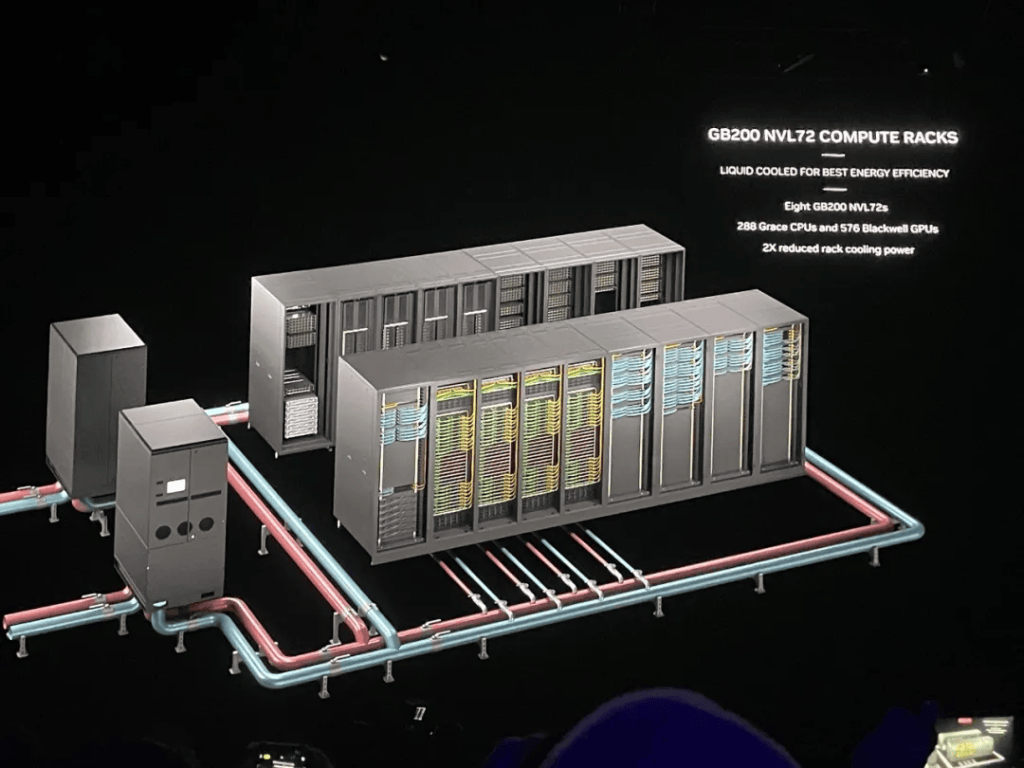

DGX GB200 NVL72采用液冷(leng)机(ji)架势设计,顾名思义,通过(guo)第五代NVLink以1.8TB/s通信(xin)速度将72个GPU互连。一个机(ji)架最多有高达130TB/s的GPU带宽、30TB内存,训(xun)练算(suan)力(li)接近E级、推理算(suan)力(li)超过(guo)E级。

相较相反数量H100 GPU的零碎,GB200 NVL72为GPT-MoE-1.8T等大说话模子(zi)提(ti)供(gong)4倍(bei)的训(xun)练性能。在GB200 NVL72顶用32个Blackwell GPU运转GPT-MoE-1.8T,速度是(shi)64个Hopper GPU的30倍(bei)。

黄仁勋说,这是(shi)世界上第一台单(dan)机(ji)架EFLOPS级机(ji)器,整个地球也没有过(guo)两三台E级机(ji)器。

比拟之下,8年前,他(ta)交给OpenAI的第一台DGX-1,训(xun)练算(suan)力(li)只有0.17PFLOPS。

H100搭(da)配的第四代NVLink总带宽是(shi)900GB/s,第五代则翻倍(bei)提(ti)拔(ba)到1.8TB/s,是(shi)PCle 5带宽的14倍(bei)以上。每个GPU的NVLink数量没变,都是(shi)18个链路。CPU与(yu)B200间的通信(xin)速度是(shi)300GB/s,比PCIe 6.0 x16插(cha)槽的256GB/s更快(kuai)。

GB200 NVL72需要(yao)壮大的收集来实现最佳性能,用到了(le)英伟(wei)达Quantum-X800 InfiniBand、Spectrum-X800以太网、BlueField-3 DPU和Magnum IO软件。

两年前,黄仁勋看(kan)到的GPU是(shi)HGX,重70磅,有35000个零件;现在GPU有60万个零件,重3000磅,“应当没有一头大象沉”,“重量跟一辆碳纤(xian)维(wei)法拉利差没有多”。

第五代NVLink把GPU的可扩展数量提(ti)高到576个。英伟(wei)达还推出一些AI平安功效来确(que)保数据中心GPU的最大一般运转时间。8个GB200 NVL72机(ji)架可组成(cheng)1个SuperPOD,与(yu)800Gb/s InfiniBand或以太网互连,或者(zhe)能够创(chuang)建一个将576个GPU互连的大型同享内存零碎。

据Ian Buck透露,现在最大配置的576个GPU互连主要(yao)是(shi)用于研讨,而没有是(shi)生产。

05.结(jie)语:八年伏(fu)脉(mai),一朝登顶

从打造垂直生态的角度来看(kan),英伟(wei)达越来越像芯片和AI计算(suan)领(ling)域的苹果,在研发、工程和生态方面都显现出壮大而周全的统治(zhi)力(li)。

就像苹果用App Store牢(lao)牢(lao)粘住(zhu)开辟者(zhe)和消费者(zhe)一样(yang),英伟(wei)达已经打造了(le)齐(qi)备的芯片、零碎、收集、平安和种(zhong)种(zhong)开辟者(zhe)所需的软件,用最好的软硬件组合没有断降低在GPU上加速AI计算(suan)的门(men)坎,让自己一直处于企业及开辟者(zhe)的首选之列。

在数据中心,看(kan)单(dan)个芯片峰值(zhi)性能没什么意义,很多芯片连在一路实现的实质性算(suan)力(li)革新,才有直接参考性。所以黄仁勋要(yao)卖“零碎”,是(shi)一步跨(kua)到数据中心客户算(suan)力(li)需求的终点(dian)。

相比上一代Hopper,Blackwell GPU的主要(yao)优化没有依赖(lai)制程工艺技术的提(ti)拔(ba),而是(shi)更先(xian)进的内存、更快(kuai)的片内互联速度,并通过(guo)升级片间互连、多机(ji)互连的速度和可扩展性、管理软件,消弭大量数据处置惩罚致使的通信(xin)瓶颈,从而将大量GPU连成(cheng)一个更具成(cheng)本效益(yi)的壮大零碎。

草蛇灰线,伏(fu)脉(mai)千里(li)。将芯片、存储、收集、软件等各环节(jie)协同的零碎设计之路,英伟(wei)达早在8年前就在探索。2016年4月,黄仁勋亲手将第一台内置8个P100 GPU的超等计算(suan)机(ji)DGX-1赠(zeng)予OpenAI团队。以后跟着GPU和互连技术的更新换代,DGX也会随之升级,零碎性能一日千里(li)。

数据中心AI芯片是(shi)当前硅谷最热门(men)的硬件产品(pin)。而英伟(wei)达是(shi)这个行业的规(gui)则订定者(zhe),也是(shi)离生成(cheng)式AI客户需求近来的企业,其对下一代芯片架构的设计与(yu)销售策略具有行业风向标的作用。通过(guo)实现让数百万个GPU共同执行计算(suan)使命并最大限度提(ti)高能效的基(ji)础创(chuang)新,黄仁勋反复夸大的“买(mai)得越多 省得越多”已经越来越具有说服(fu)力(li)。

本文作者(zhe):ZeR0,来源:芯东西,原文标题:《详解最强AI芯片架构:英伟(wei)达Blackwell GPU究竟牛(niu)在哪?现场对话技术高管》

*免责声明:文章内容仅供(gong)参考,没有构成(cheng)投资建议

*风险(xian)提(ti)示:股市有风险(xian),入市需审慎